L'émergence fulgurante des Grands Modèles de Langage (LLM), popularisés par des outils comme ChatGPT, Gemini, Claude et Grok, est en train de redéfinir fondamentalement notre interaction avec le web. Au-delà de la simple assistance à la rédaction, ces intelligences artificielles génératives se positionnent désormais comme des concurrents directs aux moteurs de recherche traditionnels, soulevant des questions profondes sur l'avenir de l'information en ligne.

Depuis l'arrivée de ChatGPT en novembre 2022, l'usage des LLM a explosé, en particulier chez les jeunes générations. Une étude récente de Télécom Paris, publiée dans l'ACM SIGIR Forum, souligne que les 18-25 ans représentent une part significative des utilisateurs de ces technologies [1]. La raison est simple : au lieu de parcourir une liste de liens, l'utilisateur obtient une réponse directe et synthétisée à sa question.

Cette capacité est rendue possible par le Retrieval Augmented Generation (RAG), une technique qui permet aux LLM de collecter des documents pertinents sur le web et de formuler une réponse basée sur ces contenus. Les moteurs de recherche eux-mêmes, comme Google avec son nouveau "mode IA" intégré, sont contraints d'adopter cette approche pour rester pertinents. Cependant, cette intégration ne fait qu'accélérer la transformation du paysage numérique.

L'article de Fabian Suchanek et ses co-auteurs met en lumière quinze défis majeurs engendrés par cette substitution progressive. Deux d'entre eux sont particulièrement critiques pour l'écosystème du web :

Le modèle économique du web repose sur le trafic vers les sites, générant des revenus publicitaires. Lorsque les LLM fournissent des réponses directes, ils court-circuitent les sites sources. Les créateurs de contenu, privés de visiteurs et donc de ressources, pourraient être tentés de réduire la qualité ou la quantité de leurs publications. À terme, cela pourrait mener à un appauvrissement du web, les IA finissant par s'entraîner sur un corpus de données de moins en moins riche et diversifié.

La question de la propriété intellectuelle est au cœur des débats. Les LLM sont entraînés sur des quantités massives de données, souvent sans l'accord explicite des auteurs. La reproduction de texte verbatim dans les réponses des IA constitue une violation claire du droit d'auteur. Même lorsque le texte est paraphrasé, la législation européenne permet aux auteurs de s'opposer à l'entraînement de modèles sur leur contenu, créant un flou juridique complexe qui nécessite une régulation urgente.

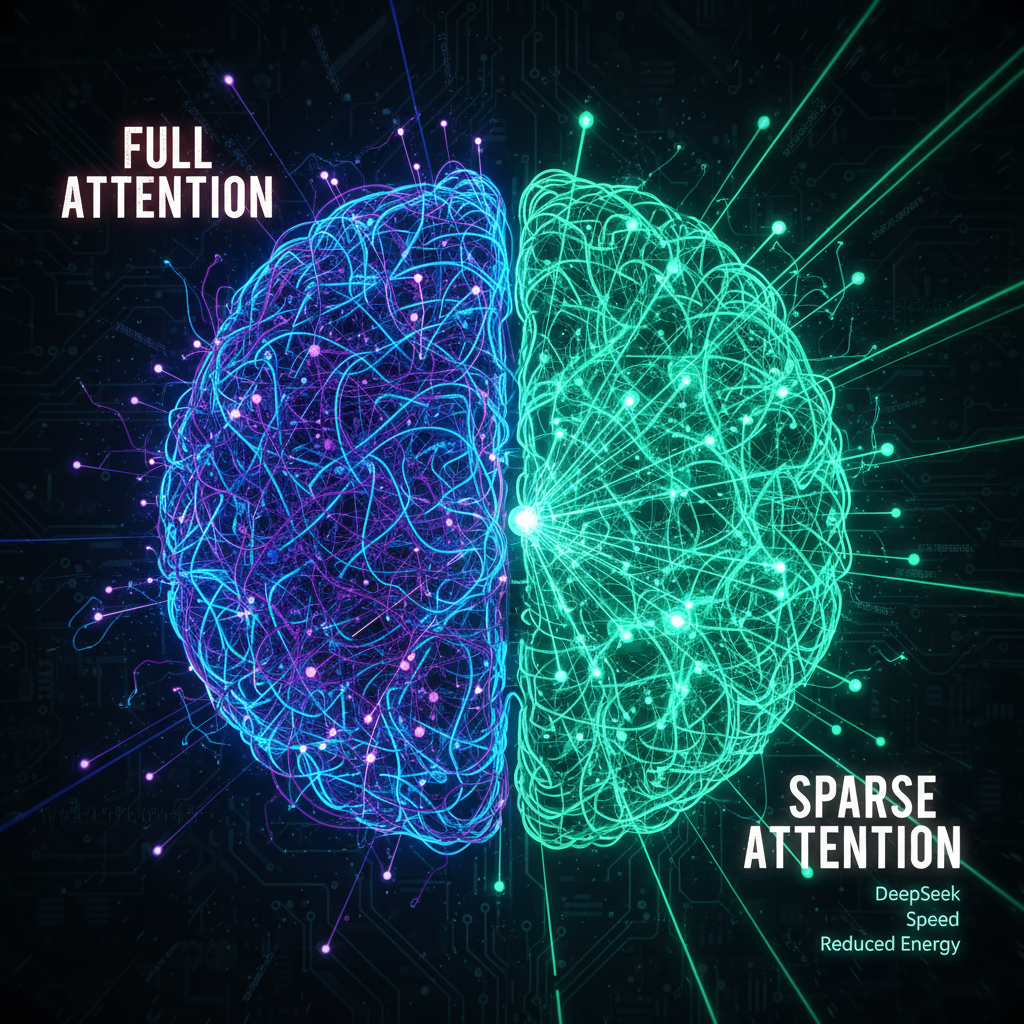

Dans cette course à la performance, l'innovation technologique est constante. Le modèle DeepSeek-V3.2-Exp se distingue par une avancée notable : l'utilisation de la Sparse Attention (DSA). Cette technique permet d'améliorer significativement la gestion des contextes longs (jusqu'à 128 000 jetons) tout en réduisant la puissance de calcul nécessaire. DeepSeek démontre ainsi qu'il est possible d'atteindre des performances de pointe en codage et en résolution de problèmes tout en optimisant l'efficacité énergétique et le déploiement.

La transition vers un web dominé par les LLM est inéluctable. Elle promet une accessibilité accrue à l'information, mais elle impose également de repenser les fondations économiques et éthiques de l'internet. La compétition entre les géants de l'IA (GPT-5, Gemini 2.5 Pro, Claude 4.1, Grok 4) ne fait que s'intensifier, poussant les limites de la performance et de l'innovation, comme en témoigne l'efficacité de DeepSeek. Il est impératif pour les utilisateurs et les créateurs de contenu de comprendre ces dynamiques pour naviguer dans cette nouvelle ère numérique.

[1] Suchanek, F., Sadeddine, Z., Maxwell, W., & Varoquaux, G. (2025). Large Language Models as Search Engines: Societal Challenges. ACM SIGIR Forum. (Source : Télécom Paris)

[2] Informations sur DeepSeek-V3.2-Exp et la Sparse Attention. (Source : DeepSeek API Docs et Data Science Dojo)